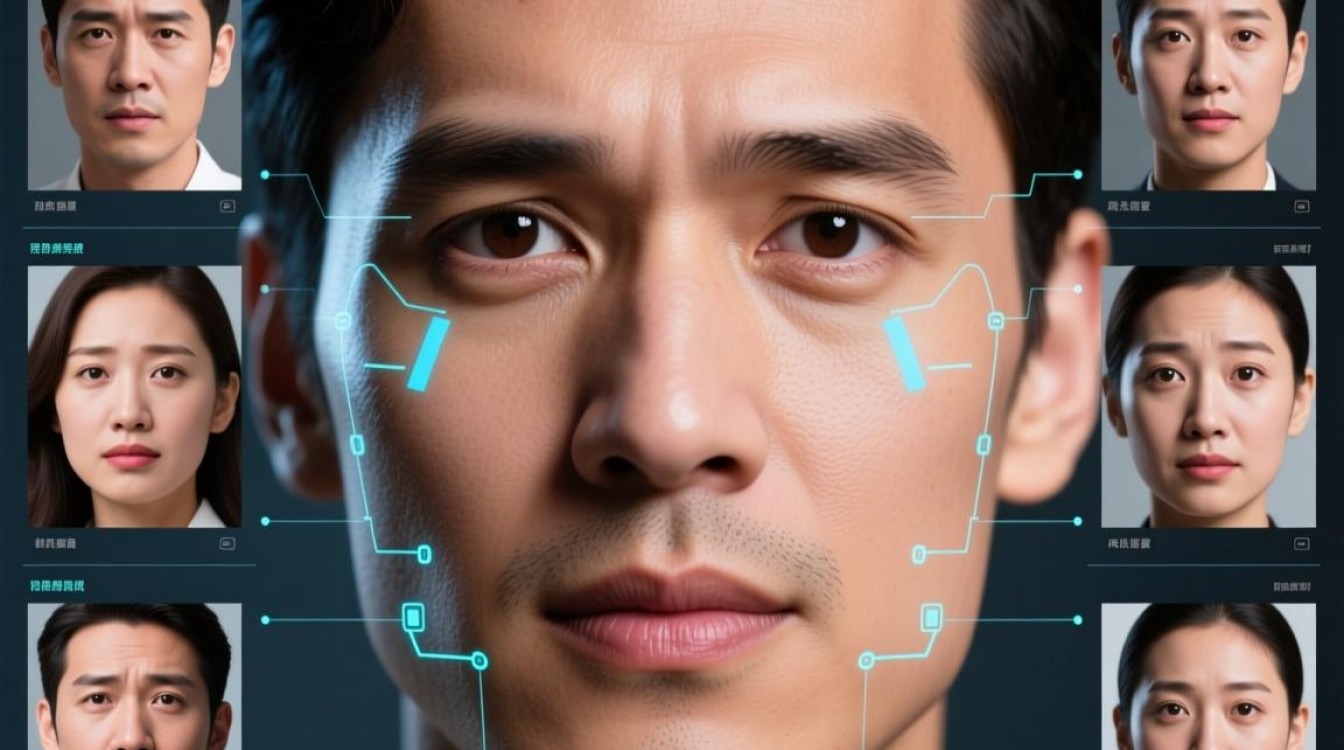

表情识别是人工智能领域一个引人入胜的分支,它旨在通过分析面部图像或视频,自动判断人类的情绪状态,传统方法依赖于人工设计的特征提取器,过程繁琐且效果有限,随着深度学习技术的崛起,表情识别迎来了革命性的突破,实现了从“人工定义”到“机器自主学习”的跨越,极大地提升了识别的准确率和鲁棒性。

深度学习之所以能在此领域大放异彩,核心在于其强大的特征学习能力,以卷积神经网络(CNN)为代表的模型,能够自动从海量数据中学习到从低级边缘、纹理到高级面部部件(如眼睛、嘴巴)乃至完整表情的层次化特征表示,这种端到端的学习模式,不仅解放了人力,更能捕捉到人类难以察觉的细微表情线索。

核心深度学习模型架构

在表情识别任务中,多种深度学习模型各显神通,共同推动了技术边界的拓展。

卷积神经网络(CNN)的基石作用

CNN是处理图像数据的绝对主力,通过卷积层和池化层的堆叠,CNN能够有效提取面部关键区域的空间特征,经典的架构如VGGNet、ResNet等,通过增加网络深度和使用残差连接,解决了深层网络训练难的问题,在静态图像的表情识别上取得了卓越成就,它们的优势在于对平移、缩放等形变具有一定的不变性。

捕捉时序动态的循环神经网络(RNN)

人类的表情是一个动态过程,仅仅依赖单帧图像会丢失大量信息,循环神经网络,特别是其变体长短期记忆网络(LSTM)和门控循环单元(GRU),专为处理序列数据而生,在视频表情识别中,CNN负责提取每一帧的空间特征,而RNN则负责分析这些特征随时间的变化规律,从而准确识别从“中性”到“喜悦”的完整动态过程。

混合模型与注意力机制

为了兼顾空间与时间维度,研究者们提出了CNN与RNN的混合模型,如CNN-LSTM架构,让模型既能“看懂”画面,又能“理解”过程,近年来,源自自然语言处理领域的Transformer模型及其核心的“自注意力机制”也被引入表情识别,它能让模型在处理图像时,自动关注到对表情判断最关键的区域(上扬的嘴角、紧锁的眉头),而非平均处理所有像素,进一步提升了模型的精度和可解释性。

下表对不同模型的特点进行了简要对比:

| 模型类型 | 核心优势 | 典型应用场景 | 主要局限性 |

|---|---|---|---|

| CNN | 强大的空间特征提取能力 | 静态图像表情识别 | 对时序信息不敏感 |

| RNN/LSTM | 擅长处理序列数据,捕捉时间依赖 | 视频、动态表情识别 | 存在梯度消失/爆炸问题,难以处理长序列 |

| CNN+RNN | 结合空间与时间特征,模型更全面 | 视频流实时表情分析 | 模型结构复杂,计算成本较高 |

| Transformer | 全局注意力机制,捕捉长距离依赖关系 | 高精度、复杂场景下的表情识别 | 需要大量数据进行预训练,计算资源需求巨大 |

应用前景与前沿挑战

基于深度学习的表情识别技术已渗透到众多领域,在人机交互中,它能赋予机器“察言观色”的能力,创造更自然的交互体验;在智能驾驶领域,实时监测驾驶员的疲劳或分心状态,可极大提升行车安全;在医疗健康和市场营销中,它也展现出巨大的应用潜力。

该技术仍面临挑战,在光照多变、姿态各异、存在遮挡的“野生”环境下,模型的准确率会显著下降,数据集的偏差可能导致模型对不同种族、年龄群体的识别存在不公平性,如何构建更具泛化性、公平性和隐私保护能力的表情识别系统,将是未来研究的核心方向,随着多模态融合(结合语音、文本等信息)和更高效算法的发展,我们有理由相信,表情识别技术将变得更加智能和可靠。