在当今数字化转型的浪潮中,虚拟化技术已成为企业IT架构的核心支柱,通过虚拟机(Virtual Machine, VM)技术,单一物理服务器能够高效运行多个独立操作系统,极大提升了资源利用率与灵活性,随着虚拟机密度的增加和业务负载的复杂化,性能瓶颈问题日益凸显,虚拟机WA(Write Amplification)高达80%”已成为困扰运维团队的关键指标,本文将深入剖析虚拟机WA现象的成因、影响及优化策略,为构建高性能虚拟化环境提供实践参考。

理解虚拟机WA:定义与表现

WA(Write Amplification)即“写放大”,最初在存储领域用于描述实际写入数据量与有效数据量之间的比值,在虚拟化场景中,WA进一步扩展为:虚拟机因虚拟化层开销、存储系统特性等因素,导致实际I/O操作量远超虚拟机自身产生的有效I/O量,当虚拟机WA达到80%时,意味着每1MB的有效数据写入,可能触发高达1.8MB的实际I/O操作,这种“无效写入”的激增会直接拖累系统性能。

具体表现为:虚拟机磁盘I/O延迟飙升(如从毫秒级跃升至秒级)、应用响应缓慢、存储队列堆积,甚至触发物理存储设备的性能阈值,在高负载场景下(如数据库事务、高频日志写入),WA问题会被进一步放大,严重时可能导致虚拟机宕机或服务中断。

虚拟机WA高达80%的核心成因

虚拟机WA是多重因素叠加的结果,需从虚拟化层、存储系统、应用行为三个维度拆解:

虚拟化层的I/O路径开销

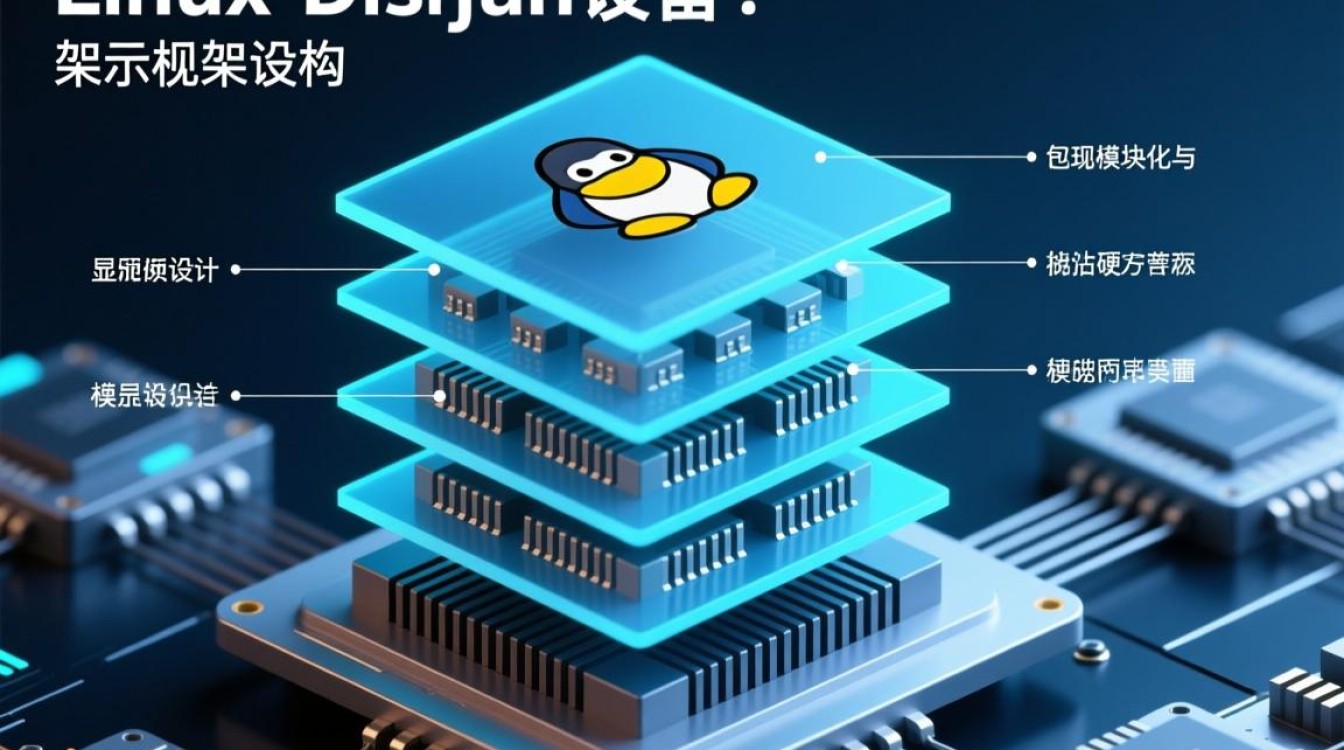

虚拟机I/O需经过“虚拟机→虚拟机监控器(Hypervisor)→虚拟磁盘→物理存储”的完整路径,在此过程中,Hypervisor会执行额外的I/O操作,如:

- 日志记录与快照:为支持虚拟机快照、高可用(HA)等功能,Hypervisor需跟踪磁盘块变化,导致每次写入产生额外的元数据写入;

- 缓存管理:Hypervisor或虚拟机工具(如VMware Tools、QEMU Guest Agent)的缓存机制可能引发“写回放大”,即临时缓存未及时刷新,导致重复写入;

- I/O调度器争抢:多个虚拟机共享物理存储的I/O调度器时,队列竞争会放大写入延迟,间接增加重试写入量。

存储系统的固有特性

底层存储架构是WA的主要诱因之一:

- 精简配置(Thin Provisioning):当虚拟机磁盘空间超分配时,物理存储需动态分配新块,导致“写时分配”(Allocate-on-Write)放大;

- 重复数据删除与压缩:存储系统为提升空间利用率,会对写入数据进行去重与压缩,但计算过程会消耗额外I/O,且小数据块去重可能引发“碎片化写入”;

- RAID校验计算:RAID 5/6需通过异或运算生成校验盘数据,当写入小块数据时,需读取整个条带(Stripe)进行校验,再重新写入,导致“读-修改-写”放大。

虚拟机内部的行为模式

应用层的写入习惯直接影响WA水平:

- 小文件频繁写入:如日志文件、临时缓存等场景,大量4KB、8KB的小块随机写入会触发存储系统的“写入放大效应”;

- 无序写入与碎片化:虚拟机磁盘长期使用后,文件系统碎片化会导致写入操作分散,增加寻址时间与I/O次数;

- 数据库事务日志:数据库的预写日志(WAL)机制需顺序写入,但结合虚拟化层后,可能因缓存策略转变为随机写入,放大WA。

WA高达80%的连锁影响

虚拟机WA的持续高企会引发系统性风险,从用户体验到基础设施成本均受波及:

- 应用性能劣化:I/O延迟直接关联应用响应时间,例如电商订单系统可能因磁盘写入超时导致交易失败,在线教育平台可能出现视频卡顿;

- 存储寿命缩短:对于SSD等闪存设备,写入放大会加剧NAND闪存单元的磨损,缩短存储设备寿命,增加硬件更换成本;

- 资源浪费:无效I/O占用了宝贵的存储带宽与网络资源,迫使企业过度配置硬件,造成“性能冗余”与成本浪费;

- 运维复杂度提升:WA问题难以通过单一手段解决,需跨虚拟化、存储、应用团队协同排查,排查周期长、调试成本高。

优化策略:从“被动应对”到“主动治理”

针对虚拟机WA高达80%的问题,需通过“监控诊断—架构优化—参数调优”三层体系化方案逐步化解:

精准监控与根因定位

- 部署I/O监控工具:利用

iostat、vmstat等系统工具,或Zabbix、Prometheus等监控平台,采集虚拟机磁盘I/O指标(如await、%util、svctm),结合存储阵列的I/O历史数据定位异常时段; - 分析WA来源:通过虚拟机监控(如vSphere的

esxtop)观察Hypervisor层I/O开销,使用blktrace追踪Linux虚拟机内部I/O路径,判断问题是否源于虚拟化层或存储层; - 模拟负载测试:通过

fio、iozone等工具复现高WA场景,对比不同配置下的I/O行为,验证优化效果。

架构优化:从源头减少写放大

- 选择合适的存储协议:对于高I/O负载的虚拟机,采用NVMe over Fabrics(如RDMA)替代传统SATA/SAS,降低延迟;对延迟敏感的应用(如数据库),考虑使用直通磁盘(Passthrough Disk)绕过虚拟化层I/O调度;

- 优化存储配置:避免在虚拟机磁盘上启用“快照链过长”,定期合并快照;对高写入负载的虚拟机使用“厚置备延迟置零”(Eager Zeroed Thick)磁盘,减少写入时的空间分配开销;

- 分离I/O流:将虚拟机系统盘、数据盘、日志盘分别部署到不同的存储LUN或SSD分区,避免I/O争抢。

参数调优:精细化控制I/O行为

- 调整文件系统参数:在Linux虚拟机中,通过

tune2fs调整dir_index、lazy_journal_init等参数,提升ext4文件系统写入效率;对Windows虚拟机禁用“磁盘碎片整理计划”,改用SSD优化工具; - 优化Hypervisor配置:在vSphere中调整“磁盘调优器”(Disk Scheduler)为“CPU调度”(CPU Scheduler),或关闭内存的“内存页共享”(Memory Page Sharing)以减少I/O干扰;在KVM环境中,调整

virtio-blk驱动的iothread参数,将I/O操作独立到单独线程; - 应用层优化:引导开发团队采用“批量写入”替代“频繁小写入”,例如将日志缓冲区大小从默认4KB提升至64KB;对数据库启用“写前日志(WAL)归档”,减少实时写入压力。

虚拟机WA高达80%并非不可逾越的性能鸿沟,而是虚拟化技术深度应用中需正视的“成长烦恼”,通过理解其背后的技术原理,结合监控、架构、参数三层优化手段,企业可有效降低写放大,释放虚拟化潜力,随着存储级内存(SCM)、计算存储(Composable Storage)等技术的成熟,虚拟机I/O效率将迎来新一轮突破,但“以数据为中心”的优化思路始终是构建高性能虚拟化环境的核心准则,唯有持续迭代、主动治理,才能让虚拟化技术在数字化转型中真正“轻装上阵”。