在当今的数据科学和机器学习领域,拥有足够的GPU算力对于处理复杂计算任务至关重要。本文将探讨GPU服务器的算力需求,并提供一些实用的建议来帮助你选择合适的服务器配置。

GPU服务器算力概述

GPU(图形处理单元)服务器专为并行处理设计,非常适合于深度学习、科学模拟、图像和视频处理等任务。GPU算力通常以浮点运算次数(FLOPS)来衡量,包括单精度(FP32)和双精度(FP64)。

确定GPU算力需求

选择GPU服务器时,需要考虑以下因素:

任务类型:不同的任务对算力的需求差异很大。例如,深度学习训练通常需要大量FP32算力,而科学计算可能需要更多FP64算力。

数据规模:处理的数据量越大,所需的算力就越高。

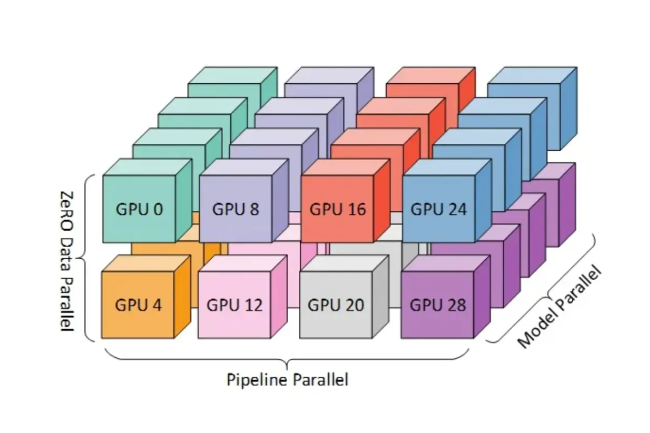

并发需求:如果需要同时处理多个任务,可能需要更多的GPU资源。

预算:更高的算力通常意味着更高的成本,因此需要平衡性能和预算。

选择合适的GPU服务器配置

根据不同的应用场景,以下是一些基本的配置建议:

对于初学者和小型项目

单个GPU:对于入门级的深度学习项目或小型企业应用,一个具有中等算力的GPU(如NVIDIA的RTX 2060或GTX 1660)通常足够。

内存:至少需要6GB的视频内存(VRAM),12GB或以上更佳。

对于中等规模的项目

双GPU:对于中等规模的深度学习任务,两个RTX 3070或更高级别的GPU将提供足够的算力。

内存:每个GPU至少12GB VRAM,建议达到24GB或更高。

对于大规模项目和企业级应用

多GPU配置:对于大型数据集和复杂模型,可能需要配置4个或更多的RTX 3090或类似级别的GPU。

内存:每个GPU至少24GB VRAM,对于特别大的模型,甚至需要32GB或更多。

GPU服务器算力的未来趋势

随着技术的进步,未来的GPU算力将不断提升,AI和机器学习任务的复杂度也在增加。因此,选择可扩展性强、支持未来升级的GPU服务器配置是非常重要的。

以下是关于GPU服务器算力的常见问答:

问:初学者学习深度学习应该选择什么GPU?

答:建议从NVIDIA RTX 3060(12GB)或RTX 4090开始,显存至少12GB以运行大多数教程模型,消费级显卡性价比高且兼容主流框架。

问:除了GPU数量外,还有哪些因素会影响GPU服务器的算力?

答:除了GPU数量外,单卡性能(如核心数、显存容量、带宽等)、服务器架构(如CPU性能、内存容量、存储速度等)以及网络连接速度都会影响GPU服务器的整体算力。因此,在选择GPU服务器时,需要综合考虑这些因素。

问:云服务商提供的T4、V100、A100有什么区别?

答:T4适合推理(低功耗),V100是上一代训练卡,A100是目前主流训练卡。算力对比:1块A100 ≈ 2块V100 ≈ 58块T4(训练场景)。

问:如何判断是否需要多GPU而不是单块更强GPU?

答:当出现以下情况考虑多GPU:1) 单卡显存不足 2) 训练时间过长 3) 需要服务更高并发。注意多GPU并行需要框架支持且通信可能引入开销。