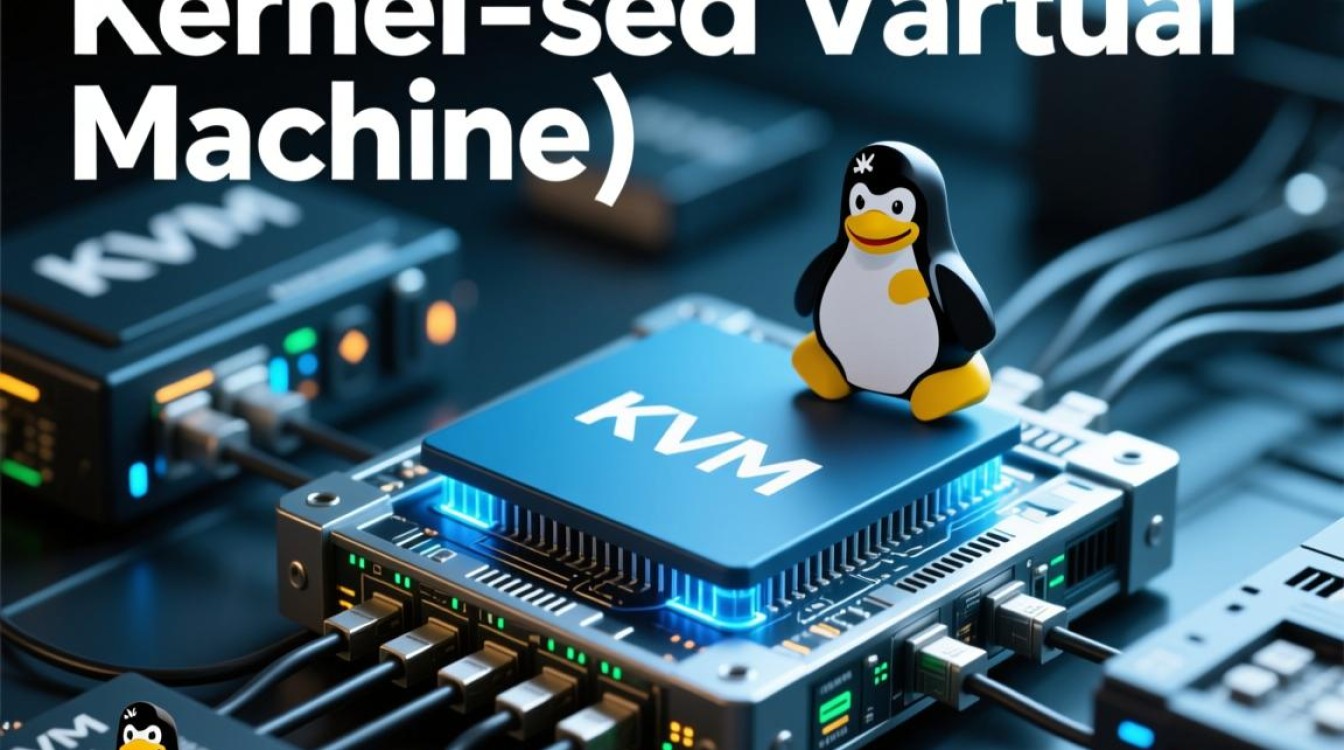

KVM(Kernel-based Virtual Machine)作为Linux内核中原生的虚拟化技术,已经成为当今云计算基础设施和OpenStack等私有云平台的底层核心,其核心上文归纳在于:KVM通过将Linux内核转变为一个Hypervisor,利用硬件辅助虚拟化技术实现了接近原生的计算性能,并结合QEMU提供设备模拟,构建了一个高性能、高安全性且极具扩展性的企业级虚拟化开发环境。 掌握KVM虚拟机开发,不仅需要理解内核模块的加载机制,更需深入内存虚拟化(EPT/NPT)、I/O虚拟化(Virtio)以及设备直通(VFIO)等关键技术栈。

KVM架构原理与运行机制

KVM的本质是一个特殊的内核模块,即kvm.ko,它并非一个传统的模拟器,而是将Linux内核本身转变为一个简单的Hypervisor,当KVM模块被加载时,Linux内核的核心功能依然保持运行,但在模式上发生了转变:它拥有了客户机模式和根模式。

在开发视角下,KVM利用了硬件的虚拟化扩展技术(如Intel VT-x或AMD-V),当客户机操作系统执行敏感指令时,CPU会自动从客户机模式退出,陷入根模式,由KVM捕获并处理这些指令,这种设计使得KVM本身非常精简,大部分传统硬件设备的模拟工作(如BIOS、显卡、网卡)都交由运行在用户空间的QEMU(Quick Emulator)进程负责,这种内核态与用户态的分工协作,是KVM开发架构设计的精髓,既保证了内核的安全性,又利用了QEMU丰富的设备模型支持。

内存虚拟化与地址转换的高效实现

在KVM虚拟化开发中,内存管理是性能优化的重中之重,客户机操作系统使用的是虚拟地址(GVA),经过自身页表转换为客户机物理地址(GPA),这些地址在宿主机看来并非真实的物理内存地址,必须再次转换为宿主机物理地址(HPA)。

为了解决这种“双重地址转换”带来的巨大性能开销,现代硬件引入了扩展页表技术,EPT在硬件层面实现了GPA到HPA的直接映射,使得内存转换的大部分工作由硬件MMU自动完成,极大地减少了VM-Exit(虚拟机退出)的次数,在KVM开发调优中,合理配置大页内存可以进一步减少TLB(Translation Lookaside Buffer)缺失,提升数据库等内存密集型应用的性能,开发者需要关注EPT Violation的处理逻辑,这是内存虚拟化稳定性的关键。

I/O虚拟化:从全模拟到Virtio的高效演进

I/O性能往往是虚拟化环境的瓶颈,KVM提供了三种主要的I/O虚拟化方式:全模拟、半虚拟化和直通。

- 全模拟:QEMU通过软件模拟真实的硬件设备(如e1000网卡),这种方式兼容性最好,但每次I/O操作都需要VM-Exit,由QEMU处理,上下文切换开销巨大,性能最低。

- Virtio(半虚拟化):这是KVM开发中必须掌握的核心技术,Virtio通过在客户机中安装前端驱动,与宿主机QEMU中的后端设备进行通信,两者通过共享内存和Virtqueue( virtio环形缓冲区)进行数据交换,极大减少了VM-Exit次数,在开发高性能网络存储虚拟化时,优化Virtqueue的大小、利用多队列技术是提升吞吐量的关键手段。

- SR-IOV与VFIO(设备直通):对于要求极致低延迟和高吞吐的场景,如NFV(网络功能虚拟化),直接将物理PCIe设备分配给虚拟机是最佳方案,利用VFIO框架,KVM可以将物理设备的内存空间直接映射到客户机的地址空间,实现接近裸金属的I/O性能。

KVM虚拟机的开发调试与性能调优

专业的KVM开发不仅仅是部署,更在于深度的调试与调优,开发者应熟练使用perf、ftrace等内核工具分析虚拟机的运行时状态,通过分析kvm_exit事件,可以定位导致性能下降的具体指令类型。

在CPU调度方面,KVM将客户机vCPU视为宿主机的普通进程进行调度,开发中需要注意vCPU绑定,将虚拟机的vCPU绑定到特定的物理CPU核心上,避免上下文迁移带来的缓存失效,利用CPU亲和性和NUMA(非统一内存访问)感知技术,确保虚拟机尽可能在本地内存节点上分配资源,是构建低延迟计算平台的必备策略。

随着安全需求的提升,KVM开发还需关注SEV(AMD Secure Encrypted Virtualization)或TDX(Intel Trust Domain Extensions)等机密计算技术,它们通过硬件加密内存,保护客户机数据免受宿主机恶意软件的攻击,这代表了未来虚拟化安全开发的重要方向。

相关问答

问:KVM与Docker容器在虚拟化层面有什么本质区别?

答:KVM是基于硬件辅助的系统级虚拟化,它拥有独立的Guest OS内核,实现了强隔离和完整的操作系统栈,适合运行不同OS或高安全要求的业务,而Docker是基于操作系统的容器级虚拟化,共享宿主机内核,通过Namespace和Cgroups实现资源隔离,启动速度快、资源损耗低,但隔离性相对较弱,在开发实践中,常采用KVM运行Docker的混合架构,既保证了物理隔离的安全性,又获得了容器的敏捷性。

问:如何排查KVM虚拟机网络延迟过高的问题?

答:首先应确认使用的是Virtio网卡驱动而非模拟网卡(如e1000),检查宿主机的CPU负载,确保vCPU没有被过度调度导致饥饿,利用ethtool检查多队列是否开启,以及中断亲和性是否正确配置,如果是跨宿主机通信,检查VXLAN或VLAN的封装开销,使用ping测试时,关闭虚拟机内的TSC(时间戳计数器)校准偏差,有时时钟不同步也会导致延迟测试数据不准。

互动环节

如果您在KVM虚拟化开发过程中遇到过关于Virtio驱动兼容性或者NUMA架构下的内存分配难题,欢迎在评论区分享您的具体场景,我们可以共同探讨最优的解决方案。