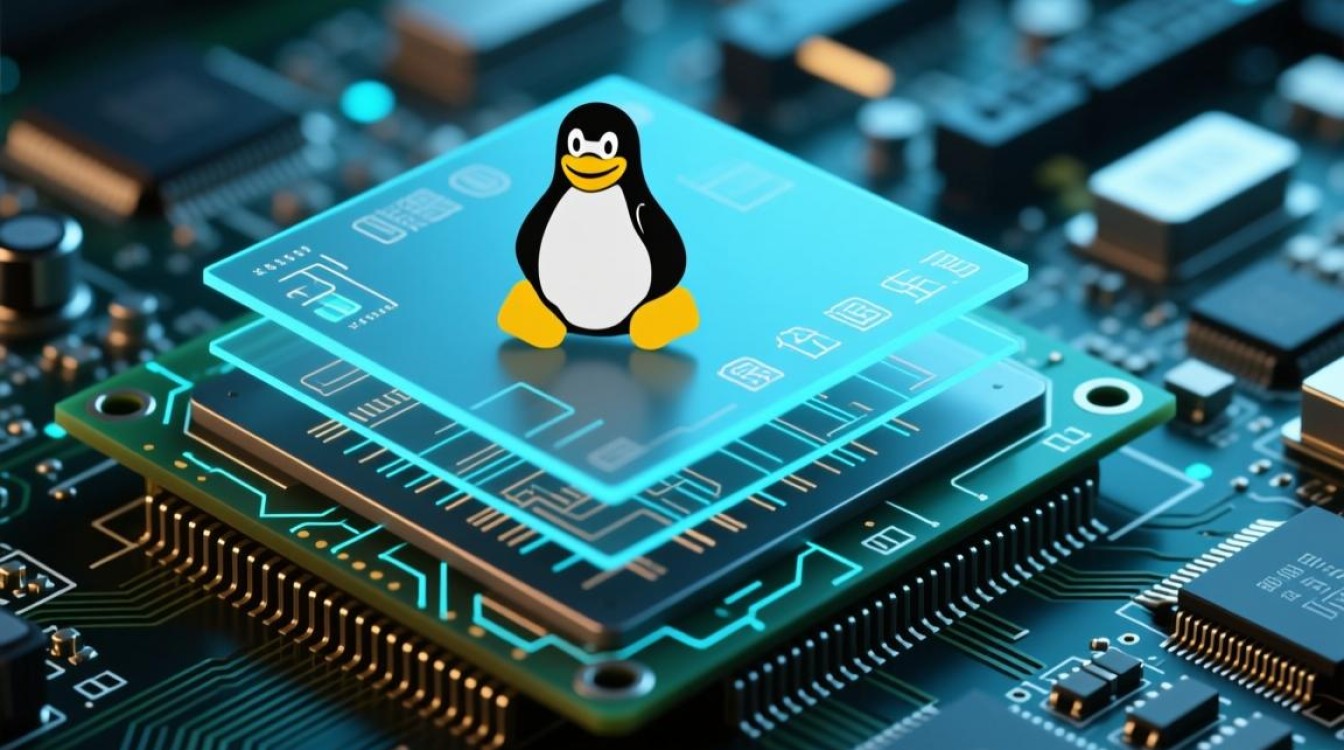

Linux在硬件层面的卓越表现,并非偶然,而是源于其内核架构对硬件资源的直接、高效调度能力,与依赖抽象层的操作系统不同,Linux通过模块化的内核设计、精确的内存管理以及高度可定制的驱动程序,实现了对CPU、内存、I/O设备及中断处理的精细化控制,掌握Linux硬件级交互机制,不仅是系统运维的核心技能,更是实现高性能计算、低延迟服务器及嵌入式开发的关键所在,要实现真正的硬件级性能优化,必须深入理解内核空间与用户空间的边界、设备驱动的工作原理以及硬件中断的响应流程。

内核空间与硬件交互的底层逻辑

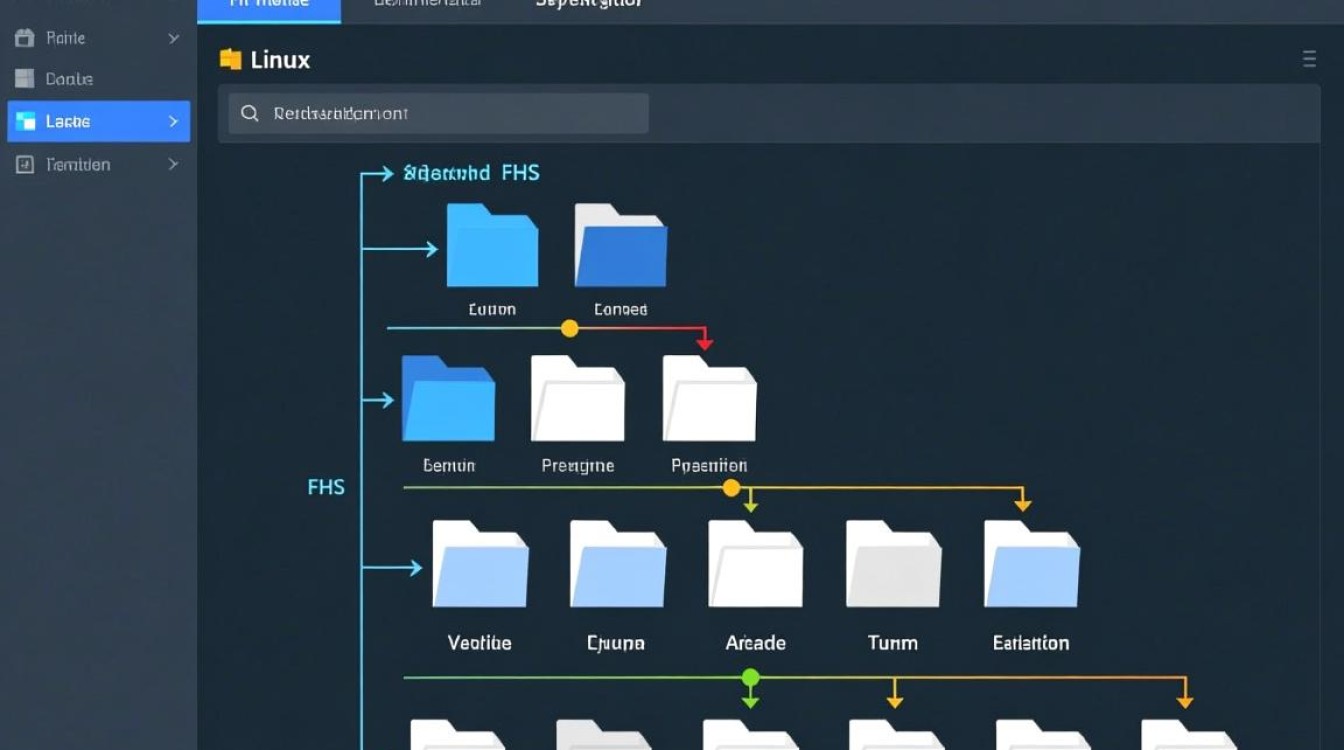

Linux系统将运行环境划分为内核空间和用户空间,这种隔离机制保障了系统稳定性,同时也决定了硬件访问的效率,所有对硬件的直接操作都必须在内核空间完成,当用户空间的应用程序需要访问硬件(如读取磁盘数据)时,会通过系统调用触发软中断,CPU从用户态切换至内核态。

在这一过程中,虚拟文件系统(VFS)起到了关键的桥梁作用,它屏蔽了不同硬件文件系统的差异,为上层提供统一的接口,而在更底层,内核通过设备驱动程序直接与硬件控制器通信,对于高性能场景,减少用户态与内核态的上下文切换是优化的重点,使用mmap(内存映射)技术,可以将设备内存直接映射到用户空间,从而绕过内核缓冲区的数据拷贝,显著提升I/O密集型应用的性能。

设备驱动与硬件兼容性架构

Linux硬件支持的广泛性得益于其模块化内核设计,驱动程序既可以编译进内核镜像,也可以作为可加载模块(.ko文件)动态加载,这种灵活性使得系统在不重启的情况下就能支持新硬件。

在硬件识别阶段,Linux内核通过设备树或ACPI(高级配置与电源接口)来获取硬件拓扑信息,对于x86架构服务器,ACPI提供了标准化的硬件描述;而在嵌入式领域(如ARM架构),设备树则负责描述硬件的详细信息,理解这一点对于硬件级故障排查至关重要,因为硬件加载失败往往源于描述文件与实际硬件配置不匹配。

Linux社区对主线内核的坚持保证了驱动的高质量,相比于厂商提供的闭源驱动,合并进主线内核的代码经过了严格的代码审查和社区测试,通常具有更好的稳定性和安全性,在企业级应用中,优先选择开源主线驱动是保障硬件长期稳定运行的最佳实践。

硬件级性能调优的核心策略

硬件级调优的本质是减少资源争用与降低延迟,这需要针对具体的硬件组件进行精细化的参数调整。

在CPU调度方面,Linux内核使用 Completely Fair Scheduler (CFS) 算法,但在硬件层面,通过CPU亲和性绑定,可以将关键进程锁定在特定的CPU核心上,减少CPU缓存失效带来的性能损耗,调整CPU频率调节器,在高性能场景下将其设置为performance模式,避免CPU因动态调频而产生的延迟波动。

在I/O存储层面,选择合适的I/O调度算法至关重要,对于SSD等高速存储设备,传统的CFQ算法可能成为瓶颈,而使用noop或deadline调度算法往往能获得更低的延迟。大页内存的使用可以有效减少Translation Lookaside Buffer (TLB) 的缺失率,对于内存密集型数据库(如Oracle、Redis),开启Huge Pages能带来显著的性能提升。

网络硬件的调优则侧重于中断处理,传统的网络包处理会导致频繁的CPU中断,影响系统吞吐量,现代Linux通过NAPI(New API)混合中断与轮询技术,在高负载下自动切换为轮询模式,大幅提升了网络处理能力,更进一步,使用DPDK或XDP等技术,可以绕过内核协议栈,实现用户态直接驱动网卡,达到线速处理的能力。

硬件故障排查与监控机制

在硬件级运维中,Linux提供了强大的诊断工具。dmesg不仅是内核日志的输出窗口,更是硬件故障的第一道防线,硬件初始化失败、PCIe错误传输、内存ECC校验错误等信息都会第一时间出现在这里。

利用/proc和/sys虚拟文件系统,可以直接查看和修改硬件参数,通过/proc/interrupts可以监控各硬件中断在CPU核心上的分布情况,判断是否存在单核中断过载的不均衡现象。lspci和lsusb工具则能详细列出PCIe和USB总线的设备详情及带宽利用率。

对于服务器级别的硬件管理,IPMI工具允许管理员在操作系统未运行甚至系统崩溃的情况下,对服务器进行远程监控、重启和日志收集,这是硬件级管理不可或缺的最后一道防线。

相关问答

Q1:在Linux服务器中,如何判断当前磁盘I/O瓶颈是由于硬件性能限制还是内核调度策略不当?

A:首先应使用iostat -x 1查看磁盘的%iowait和await指标,如果%util接近100%且await极高,说明硬件饱和,结合iotop确认是否有进程在进行大量写操作,若硬件利用率未满但延迟高,则可能是I/O调度算法问题,对于SSD,可以尝试将调度算法切换为noop或deadline,并通过/sys/block/sdX/queue/scheduler动态调整,观察性能是否改善,检查vm.dirty_ratio和vm.dirty_background_ratio参数,避免内核脏页回写策略导致的I/O抖动。

Q2:Linux内核中的中断亲和性是如何影响网络性能的?

A:网络数据包到达网卡时,网卡会触发硬件中断通知CPU,如果多队列网卡的多个中断请求都默认发送到同一个CPU核心,该核心会成为瓶颈,导致丢包和延迟,通过/proc/irq/IRQ_NUMBER/smp_affinity文件,可以手动指定处理特定中断的CPU核心,现代Linux结合IRQ Balance服务,可以自动将中断分散到不同核心,在极高吞吐场景下,结合RPS(Receive Packet Steering)和RFS(Receive Flow Steering),在软件层面进一步模拟多队列处理,将软中断处理均匀分布,从而最大化多核CPU的网络处理能力。

如果您在Linux硬件级调优或驱动开发中有独特的经验,欢迎在评论区分享您的见解或遇到的挑战,我们可以共同探讨解决方案。